本文最初发表于我们 2022 年 7 月/8 月刊,题为“机器中的幽灵”。点击此处订阅以阅读更多此类故事。

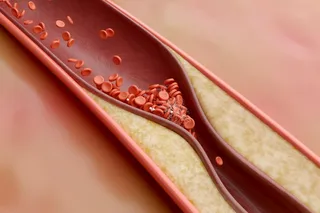

如果一次心脏病发作没有被记录下来,它真的发生过吗?对于人工智能程序来说,答案很可能是否定的。每年,估计有 170,000 名美国人 经历无症状或“静默”心脏病发作。在这些事件中,患者可能不知道是阻塞导致血液无法流动,还是重要组织正在死亡。他们不会感到胸痛、头晕或呼吸困难。他们也不会脸红或晕倒。相反,他们可能只感到有点累,或者根本没有症状。但患者可能没有意识到发生了什么,然而潜在的损伤可能非常严重且持久:经历过静默心脏病发作的人在未来 10 年内患冠心病和中风的风险更高,死亡的可能性也更大。

但是,如果医生没有诊断出那次发作,它就不会包含在患者的电子健康记录中。这种疏忽可能带来危险的后果。人工智能系统通过健康记录进行训练,筛选大量数据,研究医生过去是如何治疗患者的,并做出预测,为未来的护理决策提供信息。“这就是为什么很多医疗人工智能如此具有挑战性,”加州大学伯克利分校副教授 Ziad Obermeyer 说,他研究机器学习、医学和卫生政策。“我们几乎从未观察到我们真正关心的东西。”

阅读更多关于医学人工智能的内容

问题出在数据上——或者更确切地说,出在数据中缺失的内容上。电子健康记录只显示医生和护士注意到的东西。如果他们看不到某个问题,即使是像心脏病发作这样严重的问题,人工智能也无法看到。同样,医生可能会无意中将自己的种族、性别或社会经济偏见编码到系统中。这可能导致算法优先考虑某些人群而忽略其他人群,加剧不平等,并未能兑现人工智能可以帮助提供更好护理的承诺。

一个这样的问题是,医疗记录只能存储那些能够获得医疗系统和负担得起看医生费用的患者的信息。“数据集中未能充分代表某些群体的——无论是特定疾病的种族群体、性别,还是罕见疾病本身——都可能产生对这些群体存在偏见的算法,”斯坦福大学放射科医生兼人工智能在医学和成像中心主任 Curtis Langlotz 说。

除此之外,诊断可能与医生的先入为主的观念和想法一样,反映了医生对患者慢性疼痛原因的看法,而不是反映实际情况。“很多人工智能工具的肮脏秘密是,很多我们看似在预测的生物变量,实际上只是某人的意见,”Obermeyer 说。这意味着,这些工具并没有帮助医生做出更好的决定,反而常常在延续它们本应帮助避免的不平等。

插画:Kellie Jaeger

解码偏见

当科学家训练算法来驾驶汽车时,他们知道路上的情况。没有关于前方是否有停车标志、学校区域或行人的争议。但在医学领域,真相往往取决于医生所说的,而不是实际发生的情况。胸部 X 光片可能是肺炎的证据,因为这是医生诊断并记录在健康记录中的,而不是因为这一定是正确的诊断。“这些替代指标常常受到经济、种族、性别以及各种社会性因素的扭曲,”Obermeyer 说。

在 Obermeyer 和同事于 2019 年发表的一项研究 中,他们检查了一家名为 Optum 的医疗服务公司开发的算法。医院使用类似的算法来预测哪些患者最需要护理,每年估计覆盖超过 2 亿人。但没有一个简单的变量可以确定谁将变得最病重。Optum 的算法没有预测具体的健康需求,而是预测哪些患者的治疗费用可能更高,其逻辑是病人越病重,需要的护理越多,因此治疗费用也越高。由于收入、获得医疗服务的机会以及医生治疗不当等多种原因,黑人的平均医疗保健支出低于白人。因此,该研究的作者发现,使用成本作为健康状况的替代指标,导致算法持续低估了黑人的健康需求。

该算法并没有反映现实,而是模仿并进一步根植于医疗保健系统中的种族偏见。“我们如何让算法比我们做得更好?”Obermeyer 问道。“而不仅仅是模仿我们的偏见和错误?”

卡内基梅隆大学机器学习系的教授 Rayid Ghani 说,此外,确定情况的真相——医生是由于判断失误、种族主义还是性别歧视而犯错,还是医生只是运气好——并不总是清楚。如果一位医生进行了一项检查并发现患者患有糖尿病,这位医生做得好吗?是的,他们诊断出了疾病。但也许他们应该更早地为患者进行检查,或者在几个月前,在糖尿病发生之前,就处理他们不断升高的血糖。

如果同一次检查结果为阴性,计算就更加困难了。医生应该进行这项检查吗,还是浪费了资源?“你只能在早期诊断没有发生时,才能衡量出迟发性诊断,”Ghani 说。关于哪些检查被执行(或哪些患者的抱怨被认真对待)的决定,往往反映了临床医生的偏见,而不是最佳的医疗治疗。但是,如果病历将这些偏见编码为事实,那么这些偏见就会在从它们那里学习的人工智能系统中复制,无论技术有多好。

“如果人工智能使用相同的数据来训练自己,它就会有一些固有的偏见,”Ghani 补充道,“不是因为人工智能本身是这样的,而是因为不幸的是,人类就是这样的。”

解决不平等

约翰霍普金斯大学研究医学偏见的人类学家 Kadija Ferryman 表示,然而,如果人工智能被有意识地使用,这种缺陷可以成为一个强大的工具。她指出,一项 2020 年的研究 使用人工智能作为一种资源来评估数据所显示的内容:一种用于评估偏见的诊断。例如,如果一个算法对女性和购买了公共保险的患者的准确性较低,这就表明护理的提供并不公平。“人工智能不再是最终目的,而几乎是起点,帮助我们真正理解临床空间中的偏见,”她说。

在《Nature Medicine》杂志 2021 年的一项研究中,研究人员描述了一个他们开发的算法,用于检查诊断关节炎性膝关节疼痛中的种族偏见。历史上,黑人和低收入患者接受手术的可能性要小得多,尽管他们通常比白人患者报告的疼痛程度要高得多。医生会将这种现象归因于心理因素,如压力或社会孤立,而不是生理原因。因此,研究人员没有依赖放射科医生的诊断来预测患者膝关节疼痛的严重程度,而是使用了一个包含膝关节 X 光片和患者自身不适描述的数据集来训练人工智能。

该人工智能不仅比医生更准确地预测了谁感到疼痛,而且还表明黑人患者的疼痛不是心身性的。相反,人工智能揭示了问题在于放射科医生认为病变的膝盖应该是什么样子。由于我们对关节炎的理解植根于几乎完全针对白人群体的研究,医生可能无法识别在黑人患者中更普遍存在的病变膝盖的特征。

设计像膝关节疼痛算法这样能够纠正或检查医生偏见,而不是仅仅模仿它们的人工智能系统要困难得多——而且需要比目前更多的监督和测试。但 Obermeyer 指出,在某些方面,修复人工智能中的偏见可以比修复我们系统中的偏见——以及我们自身——要快得多,而这些偏见正是导致这些问题的原因。

构建考虑到偏见的人工智能可能是解决更大系统性问题的有前途的一步。毕竟,要改变机器的运行方式,只需要敲击几下键盘;而改变人们的想法则需要更多。

2011 年的沃森(Watson)早期原型,如图所示,最初有大师卧室那么大。(图片来源:Clockready/Wikimedia Commons)

Clockready/Wikimedia Commons

IBM 的失败革命

2011 年,IBM 的沃森(Watson)电脑在智力竞赛节目《危险边缘》(Jeopardy!)中击败了人类对手。该节目历史上收入最高的选手 Ken Jennings 在最后一轮输了超过 50,000 美元。“我个人欢迎我们新的计算机霸主,”他在答题卡上写道。

但沃森(Watson)的统治是短暂的。作为最早——也是最受瞩目——的将人工智能应用于医疗保健的尝试之一,沃森(Watson)如今已成为医疗人工智能最大的失败案例之一。IBM 花费了数十亿美元来建立一个庞大的患者信息、保险索赔和医学影像库。沃森(Watson)健康((声称)能够)利用这个数据库来建议新的治疗方法,将患者匹配到临床试验,并发现新药物。

尽管沃森(Watson)拥有令人印象深刻的数据库,并且 IBM 大力宣传,但医生们抱怨它很少做出有用的建议。该人工智能没有考虑到患者群体的区域差异、获得医疗服务的机会或治疗方案。例如,由于其癌症数据完全来自一家医院,沃森(Watson)肿瘤学系统仅仅反映了在那里执业的医生的偏好和偏见。

2022 年 1 月,IBM 最终拆解了沃森(Watson),将其最有价值的数据和分析出售给了投资公司 Francisco Partners。这次失败并没有阻止谷歌和亚马逊等其他科技巨头大肆宣传他们自己的人工智能,承诺提供能够从转录笔记到预测肾衰竭等各种功能的系统。对于那些试验医疗人工智能的大型科技公司来说,机器驱动的医生仍然非常“活跃”。