公民科学沙龙是 Discover 和 SciStarter.org 的合作项目。

在这个充斥着社交媒体机器人、深度伪造(deepfakes)和“另类事实”的时代,可靠的新闻比以往任何时候都更重要。现在,一个名为 Public Editor 的公民科学项目正在招募志愿者,通过在线分析来帮助辨别可信新闻。在指导和支持下,Public Editor 的志愿者评估新闻文章的各个部分是否存在“推理错误”和其他问题。

该项目借用了新闻机构中“公众编辑”的角色。传统上,公众编辑负责监督媒体的记者道德,有时也充当与公众的联络人。“公众编辑”项目借鉴了这一传统角色的某些方面,并借助公民科学和人工智能将其数字化。

Public Editor 的联合主任 Nick Adams 表示:“这项工作的最令人欣慰之处在于,我们能听到志愿者的声音,他们非常赞赏能够赋权给他们来对抗这个日益严峻的虚假信息问题。这些有害的影响似乎在加剧,因为错误的思维方式加速了 COVID 的传播,同时也侵蚀了我们作为一个国家社区的共同纽带。”

Public Editor 的由来?

Public Editor 是一个独立的非营利组织,最初是非营利组织 Goodly Labs 的成员与加州大学伯克利分校数据科学研究所合作的成果。Goodly Labs 的目标是提供协作技术和体验,造福社会。Adams 也是 Goodly Labs 的创始人兼首席科学家,以及 Thusly 的首席执行官,Thusly 提供 Public Editor 所使用的 TagWorks 人工智能技术,用于“协作标注”。Public Editor 的另一位联合主任是物理学家 Saul Perlmutter,他因其团队发现宇宙加速膨胀而获得了 2011 年诺贝尔物理学奖。

两人于 2015 年开始构思 Public Editor 的概念。在此过程中,他们招募了一个设计团队,其中包括认知科学家、记者、科学教育家、社会学家、图书管理员、心理学家、软件工程师以及其他专家。

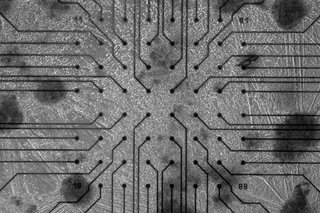

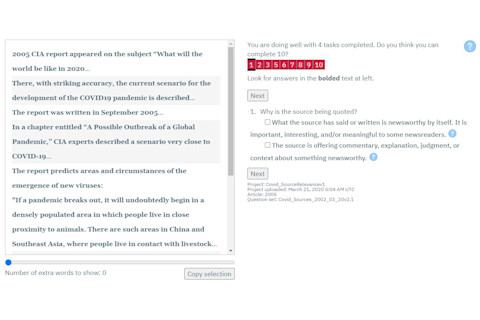

Public Editor 会培训志愿者,然后指导他们完成一系列提示,以识别新闻报道中可能存在的问题。随着越来越多的用户参与,文章会被赋予一个分数。(图片来源:Public Editor)

Public Editor

Public Editor 的工作原理

Public Editor 所使用的 TagWorks 技术旨在促进协作标注和众包分析。Public Editor 利用该技术整合志愿者关于偏见和虚假信息的反馈,然后利用群体的普遍判断来为文章生成最终的可信度得分。

可以说,TagWorks 将该非营利团队的专业知识转化为任何人都可以使用的工具。用 Public Editor 的话说,专家利用 TagWorks“设立一个由简单的标注任务组成的流水线,非专家可以完成这些任务。”

该公民科学项目将参与者分成不同的角色。一些 Public Editor 志愿者担任“分诊员”,负责选择文章段落进行审查,而另一些则担任专家编辑。这些专家编辑学习标记证据和语言的“值得称赞或有问题”的使用,对概率的讨论,以及段落内的推理。通过一套九项评估任务,志愿者可以识别出 40 多种不同类型的推理错误。

在 Public Editor 网站上,新志愿者可以从他们称之为“引用的来源专家”的 培训视频 和一组 活动 开始,然后转向其他类别,如“推理”或“论点相关性专家”。

在“引用的来源专家”任务的早期阶段,志愿者被要求高亮文本区域,“以表明记者是如何收集引述/转述的。”例如,记者可能引用某人、网站或书籍作为引述的来源。志愿者会高亮包含该引用的特定文字。

任务完成后,系统会询问用户任务的难度以及他们对自己答案的信心。“尽力而为,但不要有压力,”说明中写道。“其他人也在完成这些任务,[Public Editor] 系统将根据你们的最佳努力找到共识。”

Adams 表示:“没有人可以直接进入 Public Editor 并立即对文章的标签或评分产生影响。需要培训,并且随着时间的推移,个人用户在系统中的权重会随着良好的表现而提高。”随着他们的进步,志愿者可以获得虚拟徽章和笔记本贴纸。Public Editor 在一个团队论坛中解答志愿者的问题并建立社区,该论坛还举办线上和线下的聚会,并通过基于位置的群组连接志愿者。

要查看带有标签和评分的 Public Editor 标注文章,请查看他们的一些 示例。

解决 Public Editor 中的偏见问题

偏见和不平等是 STEM 领域长期存在的问题,而 人工智能 在性别、种族和其他身份认同方面的问题仍在持续。这对许多科技组织以及 众包信息的公民科学项目 来说都是持续的挑战。

Public Editor 通过有意识的系统和一支经过培训以发现用户偏见并加以解决的 团队,积极应对偏见问题。例如,文章在呈现时没有显示新闻机构或作者名称,但如果某个志愿者仍然比其他新闻来源更批判,Public Editor 会暂时降低其判断的权重并提供额外的培训。

Adams 表示,消除偏见是不可能的。“[但是] 特别是在一个人完成了许多任务之后,很容易看出他们是如何系统性地与队友脱节的。”他说。“我们甚至在系统中包含了一些问题和答案选项,这些选项尤其容易暴露个人的意识形态和认知偏见。”然后,Public Editor 可以将这些偏见与用户分享,并鼓励他们在未来进行纠正。

该团队还尝试构建培训过程,以防止恶意用户渗透系统。恶意企图的人需要工作数小时才能使他们的判断产生影响。届时,贡献者行为的变化将被标记,账户可能会被暂停。

但是,如果大多数志愿者持有相似的偏见,系统又如何能发现呢?

存在重叠的协议来抵消用户偏见。但是,Adams 表示,如果 Public Editor 社区变得非常同质化,例如超过 85% 来自同一个交叉群体(例如“年轻、保守、来自欧洲血统的中产阶级女性”),他们将不得不采取其他手段。“[系统] 无法获得信息表明其整体视角未能代表更广泛人群的视角,”他说。“这是我们的团队将通过其他方法发现的,例如调查我们的队友。”

Adams 表示,防止“有害偏见”的最佳方法是通过招募。

“我们正在邀请各种各样的人加入 Public Editor——认同各种文化、意识形态、阶层、传统和年龄群体的人。”他说。多样性有助于在 Public Editor 的团队成员未能纠正自身偏见时,将个体偏见“平均化”。

利用公民科学打击虚假信息

Adams 还表示,多样性使该项目的一致判断更具可信度,因为,例如,当来自多个视角的人识别出相同的推理缺陷时,“[我们] 对这个缺陷是真实且有问题的感觉更有信心。”他说,Public Editor 致力于包容性,并特别期待与那些在公共话语中历史上代表性不足的人合作。“其中一些社区目前正成为虚假信息活动的目标,这些活动试图劝阻他们的政治参与。”

除了核心的创始机构外,Public Editor 还与一些合作伙伴组织合作,并与外部事实核查机构合作。该非营利组织对与个人、私营和公共团体合作持开放态度。Public Editor 计划推出一个 Chrome 浏览器扩展程序,以便读者可以实时使用其评估。他们预计很快会获得 Google 的批准。

今天加入 Public Editor 的志愿者可以立即解决一个许多人热衷的问题:追求真相,并建立对可信信息的共同理解。

Adams 表示:“好消息是,每一个虚假信息的案例都是一个教育时刻;对 Public Editor 的志愿者和新闻读者来说都是一次学习经历。因此,我们可以把握住它,控制住它,并利用它来帮助每个人变得更具辨别力和更深思熟虑。”