这篇文章最初发表于我们2022年7月/8月的刊物,标题为“伦理方程”。点击此处订阅,阅读更多此类文章。

生死攸关的决定并不经常出现——除非你是一名医生。即使是是否需要再做一次检查这种日常选择,也可能意味着早期发现癌症肿瘤或任其扩散之间的区别。在COVID-19大流行期间,医生被迫决定哪些患者应该获得稀缺的呼吸机。无论大小,这样的决定都需要伦理考量,而这些考量很少是简单的。现在,随着人工智能在医学领域的迅速崛起,一个紧迫的问题出现了:人工智能系统能做出符合伦理的医疗决定吗?即使能,它们应该这样做吗?

如今,大多数人工智能系统都由机器学习驱动,数据驱动的算法会从它们训练的信息中自动学习模式。当新的数据被输入到算法中时,它们会根据所学到的内容输出一个决定。但是,要知道它们是如何做出决定的可能很困难,因为介于输入和输出之间的只有一堆令人眼花缭乱、不透明、无法解释的计算。

阅读更多关于医学人工智能的内容

为了了解人工智能在医学伦理决策方面的现状,《Discover》采访了布伦特·米特尔施塔特(Brent Mittelstadt),他是英国牛津互联网研究所(Oxford Internet Institute)的人工智能和数据伦理专家。

问:首先,我们能确切地知道一个算法是如何做出医疗决定的吗?

BM:是的,但这取决于算法的类型及其复杂性。对于非常简单的算法,我们可以知道决策过程的全部逻辑。对于更复杂的算法,你可能需要处理……成千上万甚至数百万条决策规则。所以,你能描绘出决策过程是如何形成的吗?当然可以。这是算法的伟大之处之一:你(通常)可以看到这些东西是如何做出决定的。当然,问题在于,如何将其转化为人类能够理解的东西呢?因为我们在做决定时,通常一次只能考虑五到九件事,而算法可以有数百万个,并且它们之间可能存在相互依赖性……这是一个非常艰巨的挑战。你往往会在算法的可解释程度与其解释的真实性之间做出权衡,以捕捉系统的实际行为。

问:我们可能无法理解它们是如何做出这些决定的,这本身就是一个伦理问题吗?

BM:是的,我认为可能是一个。我坚信,如果一个改变人生的决定是关于你的,那么你应该能够获得该决定的解释,或者至少获得一些理由,一些为什么做出该决定的原因。否则,你就有可能面临一个卡夫卡式的系统,你完全不知道事情为什么会发生在你身上……你无法质疑它,也无法从中获取更多信息。

也许有一个系统正在帮助医生做出诊断,并给出了一个建议,说:“我有86%的信心认为是COVID-19。” 在这种情况下,如果医生无法与系统进行有意义的对话来理解它是如何得出这个建议的,那么就会出现问题。医生被病人信任会为他们的最大利益行事,但医生将基于对系统与制造商声称的准确性或安全性相符的信任来做决定。

问:你能举一个人工智能系统可能为医生做出的伦理决策的例子吗?

BM:出于多种原因,我不想说有任何人工智能系统会直接做出任何形式的伦理决策。其中一个原因是,谈论自动化系统进行伦理推理是很奇怪的。而且我认为这不可能。此外,医生会非常不愿意将他们的决策权完全交给一个系统。接受系统的建议是一回事;盲目遵循该建议则是完全不同的事情。

问:你为什么认为人工智能不可能进行伦理推理?

BM:我想最简单的说法是,归根结底,这些是遵循一套规则的自动化系统。这些规则可以是关于它们如何学习事物的规则,也可以是预先编程到它们中的决策规则。所以,假设你和我通过讨论同意……在你的行为中,你应该为最多的人带来最大的可能利益。然后我们可以设计一个遵循该理论的系统。所以(该系统)通过它所有的学习、所有的决策,都在努力为最多的人带来最大的可能利益。你不会说那个系统在应用这个规则时,正在进行任何形式的伦理推理,或创造伦理理论,或做我们称之为人类伦理决策的事情——即你能提供理由和证据,并就什么是规范上正确的事情进行讨论。

但是你可以创建一个看起来像是在做出伦理决定的系统。最近有一个很好的例子。它本质上是一个系统,它有一堆由集体智慧定义的决策规则。人们立即开始测试它,试图打破它并找出它的内部规则。他们发现,只要你以(诸如)“为所有人带来最大的幸福”这样的短语结束句子,那么系统就会告诉你你提出的任何事情都是完全符合伦理的。它可以是种族灭绝,只要(它的措辞是暗示)种族灭绝能为最多的人带来最大的幸福,系统就会说,是的,这是符合伦理的,去做吧。所以,这些系统,至少在伦理推理方面,是做不到的。它们在伦理上是愚蠢的。它们实际上无法进行,因为你谈论的不是客观事实。你谈论的是规范和主观性。

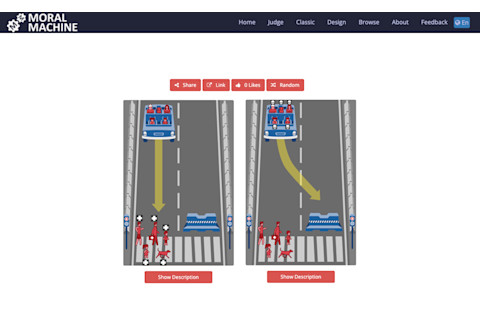

“道德机器”(Moral Machine)实验于2016年启动,它展示了一系列自动驾驶汽车可能面临的道德困境。来自世界各地的人们被要求判断哪种决定是最可接受的。大约记录了4000万次回复,以考察机器伦理的可接受原则。(致谢:www.moralmachine.net)

www.moralmachine.net

问:如果人工智能系统无法自行进行真实的伦理推理,是否还有其他方法被用来教导它们如何在有伦理组成部分的情况下做出决定?

BM:有“道德机器”实验。那是一个来自麻省理工学院(MIT)的大型全球研究项目,他们建立了一个网站和一个数据收集工具,该工具基于“电车难题”(Trolley Problem)的思想实验。其目的是让世界各地的人们经历关于自动驾驶汽车应该选择哪条车道的几种场景。在一辆车道里,你可能会有一个老年妇女和一个婴儿。在另一辆车道里,你可能会有一只狗……你可以收集大量数据,告诉你一些关于人们普遍的道德偏好或伦理观。

但这里的关键在于,所采用的方法本质上是通过集体智慧、通过多数表决的方式,为机器人或自动驾驶汽车创建道德决策规则。对我来说,这在伦理方面是倒退的。因为伦理不仅仅是大多数人认为正确的。你应该用证据、理性或只是推理来证明你的理由。有很多不同的因素可以让你接受一个伦理论证。但关键在于,这是关于论证和证据——而不仅仅是相信某事的人数。

问:你对人工智能在医疗决策中的应用还有其他哪些伦理担忧?

BM:在医学领域,一个众所周知的事实是存在着非常显著的数据缺口,其含义是,许多医学研究在历史上都是围绕着白人男性身体的观念而发展的。而对于其他人群——女性、有色人种、任何社会中的少数族裔或少数群体——数据则更差或更少……这是长期以来一直困扰医学研究和医疗决策的一个问题。如果我们用历史医学数据来训练我们的医疗(人工智能)系统——当然我们会这样做,因为这就是我们拥有的数据——那么系统就会吸收这些偏见,并可能加剧这些偏见或产生新的偏见。所以,这非常非常清楚地是一个伦理问题。但这并不是关于系统进行伦理推理并说:“你知道吗,我想对女性的表现比对男性差。” 更多的是我们社会存在偏见,而系统正在吸收它,不可避免地复制并加剧它。

如果我们进行这种思维,认为这些系统是神奇的或客观的,因为它们很昂贵,或者它们是在最佳数据上训练出来的,[或者]它们没有内置人类偏见——所有这些都是胡说八道。它们从我们这里学习。而我们创造了一个充满偏见和不平等的世界。

本次采访经过编辑和精简,以求清晰。