这听起来可能只是科幻小说里一个激动人心的情节,但研究人工智能的科学家们警告说,人工智能奇点——即技术不可逆转地超越人类心智能力的那一点——是真实存在的可能性,有些人认为它将在几十年内发生。

对人工智能专家的调查,包括2018年发表在《人工智能研究杂志》上的这项调查,往往发现有相当一部分研究人员认为,今天活着的人中,至少有50%的可能性会看到人工智能奇点的出现。有些人预计它将在未来十年内发生。

从“深蓝”到“Siri”

当人工智能达到人类智能水平的那一刻,将标志着世界的深刻变革。如此先进的人工智能可以创造更多、日益先进的人工智能。届时,控制它可能会变得困难——如果不是不可能的话。

作为背景,人工智能在1997年引起了公众的注意,当时一个名为“深蓝”的计算机程序在国际象棋领域击败了当时的国际象棋世界冠军加里·卡斯帕罗夫。最近,这项技术已被教会驾驶汽车,诊断癌症,并在手术中提供协助,以及其他应用。它甚至可以翻译语言,并在Twitter上愚弄你。当然,它还帮助我们许多人搜索网页,并为我们规划回家的路线。

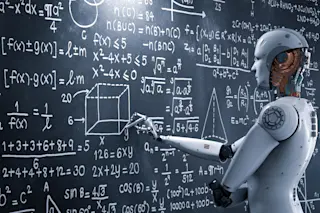

但这些都是狭义人工智能(narrow AI)的例子,它被编程来完成一个特定的、但通常极其复杂的任务。一个能够击败围棋大师的程序,无法驾驶汽车;能够识别肿瘤的人工智能,无法将阿拉伯语翻译成法语。虽然狭义人工智能在它所训练的某件事情上通常远优于人类,但它在处理人类能做的所有事情上却远远不够。与我们不同,狭义人工智能不能将其智能应用于任何出现的问题或目标。

与此同时,通用人工智能(AGI)可以将一套通用的知识和技能应用于各种任务。虽然它目前不存在,但通用人工智能将不再依赖人类设计的算法来做决策或完成任务。未来,通用人工智能可能一次又一次地构建出更聪明的人工智能。而且由于计算机的进化速度比人类快得多,这可能会很快导致所谓的“超智能”——一种远超人类智慧的人工智能。它可以适应特定情况并边学边做。这就是专家们在谈论人工智能奇点时所指的。但在这个阶段,我们可能还远远没有达到。

我们何时能迎来奇点?

在最近的一篇博客文章中,机器人学家和企业家罗德尼·布鲁克斯(Rodney Brooks)表示,他认为人工智能领域可能比大多数人想象的“落后几百年”。“我们仍然停留在燃素时代,还没有弄清楚元素,”他写道。

多伦多未来人类研究所(Human Futures Institute)的机器人工程师兼研究员沙恩·桑德森(Shane Saunderson)表示,同样重要的是要注意,我们甚至还没有弄清楚人类心智究竟是如何工作的。“考虑到我们对人类心理学和神经科学知之甚少,就断言我们离创造出类似人类的智能只有10年之遥,未免有些傲慢,”他说。“我认为我们离理解我们自己的智能还有10年,更不用说复制它了。”

尽管如此,其他人坚持认为,即使时间线不确定,也很难避免通用人工智能的出现。“除非我们人类先以其他方式消灭自己,否则它几乎是不可避免的,”在麻省理工学院研究机器学习的物理学家麦克斯·泰格马克(Max Tegmark)说。“就像制造飞机比弄清楚鸟类如何飞行更容易一样,制造通用人工智能可能比弄清楚大脑如何工作更容易。”

尽管对此问题缺乏共识,但包括已故的斯蒂芬·霍金(Stephen Hawking)在内的许多科学家都曾警告过其潜在危险。牛津大学哲学家尼克·博斯特罗姆(Nick Bostrom)在他的著作《超智能:路径、危险、策略》(Superintelligence: Paths, Dangers, Strategies)中警告说,如果人工智能发展到能够持续自我改进的地步,我们物种的命运可能取决于这个超智能机器的行为。

然而,这种命运未必一定是黯淡的。专家们也指出,超智能人工智能可能为我们许多问题提供解决方案。如果我们无法找到解决气候变化、消除贫困和实现世界和平的方法,也许人工智能可以。

“这项非凡的技术有可能帮助每个人过上健康、富裕的生活,让人类以前所未有的方式蓬勃发展,”泰格马克说,他同时也是未来生命研究所(Future of Life Institute)的创始人,该组织旨在确保这些积极的结果。然而,他也补充道,如果“其目标与我们的目标不一致,它可能会消灭人类。”或者正如博斯特罗姆在《超智能》中所说,面对智能爆炸,“我们人类就像玩炸弹的小孩子。”

为通用人工智能做好准备

无论最终它是一个万能药还是末日装置,我们可能都不想被它打个措手不及。如果人工智能奇点有合理的可能性即将到来,泰格马克认为我们应该相应地做好准备。“如果有人告诉我们,一支外星入侵舰队将在30年后抵达地球,我们就会为之做准备——而不是把它当作30年后的事情而置之不理,”他说。泰格马克指出,需要至少三十年的时间来弄清楚如何控制这项技术,并确保其目标与我们的目标一致。泰格马克认为,我们不仅需要控制它,还需要为了人类的最佳利益而使用它。

当然,这假设我们都能就我们的目标和利益达成一致。然而,泰格马克乐观地认为,我们可以在基本问题上达成共识,并共同努力,保护自己免受超智能人工智能所带来的生存威胁。如果气候灾难的威胁不足以团结人类,那么也许超智能人工智能的希望与危险都能做到。