大约在本世纪初,苏珊·安德森(Susan Anderson)正在思考一个伦理学难题。是否存在一种方法可以对相互竞争的道德义务进行排序?康涅狄格大学的哲学教授将这个问题抛给了她的计算机科学家丈夫迈克尔·安德森(Michael Anderson),认为他的算法专业知识或许能提供帮助。

当时,他正在阅读关于电影《2001:太空漫游》的制作过程,电影中宇宙飞船的计算机 HAL 9000 试图谋杀其人类船员。“我意识到当时已经是 2001 年了,”他回忆道,“而像 HAL 那样的能力已经不远了。”他认为,如果负责任地追求人工智能,那么它也需要能够解决道德困境。

在过去的 16 年里,这一信念已经成为主流。人工智能如今渗透到从医疗保健到战争的各个领域,并可能很快就会为自动驾驶汽车做出生死攸关的决定。“智能机器正在承担我们过去拥有的责任,这是一个沉重的负担,”加州理工州立大学的伦理学家帕特里克·林(Patrick Lin)解释道。“为了让我们信任它们能够独立行动,重要的是这些机器在设计时就考虑到道德决策。”

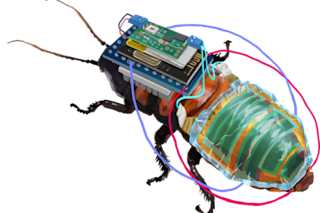

安德森夫妇将他们的职业生涯都投入到这项挑战中,并于 2010 年部署了第一台经过道德编程的机器人。不可否认,他们的机器人比 HAL 9000 的自主性要低得多。这个蹒跚学步的孩子大小的类人机器人的构想只有一个任务:确保居家老人按时服药。苏珊说,这项任务在伦理上充满挑战,因为机器人必须平衡相互冲突的义务,权衡病人的健康与对个人自主权的尊重。为了教会它,迈克尔创建了机器学习算法,以便伦理学家可以输入合乎道德的行为示例。然后,机器人的计算机可以从中推导出指导其现实生活活动的通用原则。现在,他们又向前迈进了一步。

“伦理学研究可以追溯到柏拉图和亚里士多德,那里有大量的智慧,”苏珊说道。为了利用这些智慧,安德森夫妇构建了一个接口,让伦理学家可以通过一系列提示来训练人工智能,就像哲学教授与她的学生进行对话一样。

安德森夫妇不再孤单,他们的哲学方法也不再是唯一的。最近,佐治亚理工学院的计算机科学家马克·里德尔(Mark Riedl)采取了一种截然不同的哲学方法,通过阅读故事来教授人工智能学习人类的道德。从他的角度来看,全球的文学作品比仅仅的哲学经典更能体现道德,而先进的人工智能可以借鉴这些智慧。在过去的几年里,他一直在开发这样一个系统,他称之为“堂吉诃德”——以塞万提斯的同名小说命名。

里德尔认为他的方法有一个深刻的先例。孩子们从故事中学习,故事充当“替代性体验”,帮助他们学会如何适当行为。鉴于人工智能没有童年的奢侈,他认为故事可以被用来“快速引导机器人达到一个让我们对其理解我们的社会规范感到放心的程度。”

作为初步实验,里德尔众包了关于去药房的故事。这些故事算不上引人入胜,但它们包含有用的经验。一旦程序员输入一个故事,算法就会描绘出主角的行为并学会模仿它。他的 AI 推导出一个通用的序列——排队、出示处方、付款——然后在一个类似游戏的药房模拟中进行练习。经过多轮强化学习(AI 因行为适当而获得奖励)后,AI 在模拟中得到测试。里德尔报告说成功率超过 90%。更令人惊讶的是,他的 AI 竟然学会了如何进行“罗宾汉式犯罪”,在需求紧急且资金不足的情况下偷药——这反映了人类为了更高的道德目标而打破规则的能力。

最终,里德尔希望让 AI 接触到更广泛的文学作品。“人们在写到主角时,往往会体现他们自己的文化信仰,”他说。博览群书的机器人将以符合文化的方式行事,而海量的可用文学作品应该能够过滤掉个人偏见。

加州理工学院的林认为,现在断定哪种技术是最好的还为时过早,他指出所有方法至少都具备一个积极的共同点。“机器伦理是我们了解自己的方式,”他说。教导我们的机器如何合乎道德地行事需要前所未有的道德清晰度。而这可以帮助我们完善人类的道德。

人工智能或许能教会我们哲学。

[本文最初刊登于印刷版,题为“有爱心的计算机”。]