电影《终结者2:审判日》中的虚构杀手机器人。实际上,研究人员并不太担心机器人起义,而是更关注致命自主武器的发展,这些武器将杀戮的责任从人类手中剥离。图片来源:Studio Canal | Carolco Pictures 知名科技领袖和科学家签署了公开请愿书,呼吁禁止人工智能技术驱动的致命自主武器。但最近,一群人工智能研究人员更进一步,利用抵制威胁来阻止一所大学开发所谓的杀手机器人技术。一切始于二月下旬,一家

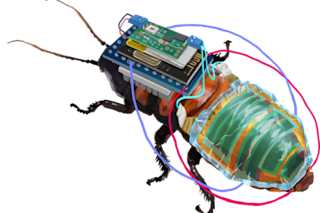

报纸报道称,韩国一家领先的国防公司与一所公立研究大学合作,开发能够无需人类监督即可运行的军事人工智能武器。到三月份,来自30个国家的50多名人工智能研究人员签署了一封公开信,致函参与该人工智能武器项目的韩国科学技术院(KAIST),声明签署者将抵制与该大学的任何研究合作。“对于开发人工智能背后科学的学者来说,重要的是这项科学要用于造福人类,”加拿大蒙特利尔大学计算机科学教授、深度学习研究的先驱Yoshua Bengio说。“在这种情况下,这涉及一所大学——而且是一所主要大学——达成一项可能开发‘杀手机器人’的协议。”《韩国时报》的文章描述了KAIST(前身为韩国高等科学技术学院)与国防公司Hanhwa Systems的联合项目,其目标是开发“应用于军事武器的人工智能(AI)技术”,可能包括“基于人工智能的导弹”、“配备人工智能的无人潜艇”和“武装四旋翼无人机”。文章还将此类自主武器定义为能够无需人类控制即可搜寻并消灭目标。美国、中国和俄罗斯等主要军事强国一直在开发可能导致致命自主武器的人工智能技术。一些现有自主武器已经能够自动追踪并攻击目标,包括哨兵炮塔或用于击落来袭导弹或飞机的武器。然而,军队将这些武器用于防御目的,并且通常会保留一名人类“在环”中做出对目标释放这些武器的最终决定。许多人工智能和机器人学研究人员希望阻止杀手机器人或不经人类命令即可射杀的无人机的广泛发展。非政府组织也组织了名为“停止杀手机器人运动”的组织,以禁止致命自主武器。甚至联合国也一直在举行一系列年度会议,讨论致命自主武器。由麻省理工学院物理学家Max Tegmark和未来生命研究所发起的2015年运动呼吁“禁止超出有意义人类控制的攻击性自主武器”。这封2015年的公开信得到了SpaceX和特斯拉创始人埃隆·马斯克、苹果联合创始人史蒂夫·沃兹尼亚克以及已故物理学家斯蒂芬·霍金等科学技术界名人的支持。此后,也陆续发布了后续的公开信和运动。

组织反抗杀手机器人

澳大利亚新南威尔士大学人工智能教授Toby Walsh一直积极参与研究界对致命自主武器开发的抵抗。因此,当KAIST-Hanhwa项目开发人工智能驱动武器的消息传出时,Walsh再次迅速采取行动。加州大学伯克利分校计算机科学与人工智能研究教授Stuart Russell表示:“在得知《韩国时报》关于‘韩国机构启动项目开发人工智能武器’的报道后,Toby Walsh(以个人身份)和停止杀手机器人运动都给KAIST校长写了信,但据我所知,没有收到任何回复。”“Toby Walsh,等待了两周后,提议进行抵制,并邀请许多研究人员签署了这封信。”这次不同的是,呼吁人工智能研究人员针对一个具体大学,因为其开发致命自主武器技术的努力。人工智能研究界的专业知识成为了与该大学未来合作的谈判工具。公开信中写道:“在联合国正在讨论如何遏制自主武器对国际安全造成的威胁之际,像KAIST这样享有盛誉的机构却着眼于加速开发此类武器的军备竞赛,这令人遗憾。”“因此,我们公开声明,在KAIST校长就该中心不会开发缺乏有意义人类控制的自主武器做出我们寻求但未获答复的保证之前,我们将抵制与KAIST任何部分的合作。”

对人工智能使用的责任

除了签署公开信,Russell还给KAIST前校长Steve Kang写了一封私人信件,试图了解KAIST与Hanhwa Systems合作的更多信息。Russell澄清说,Kang显然对Hanhwa的合同毫不知情,因为KAIST-Hanhwa协议是在Kang担任KAIST校长之后正式确立的。Russell承认,他通常对抵制“有所顾虑”。但在此情况下,他认为针对KAIST的抵制提议是“恰当的”,因为人工智能研究界已经公开表明了广泛的共识,即反对致命自主武器。蒙特利尔大学的Bengio也通过签署致韩国大学的公开信,支持了对KAIST的研究抵制提议。他此前曾支持2015年呼吁禁止致命自主武器的公开信,并且还在2017年秋季签署了一封专门致加拿大总理的信。“机器现在以及可预见的未来,对道德价值观、心理学和社会问题都没有任何理解,”Bengio解释说。“因此,当涉及到人们的生命、福祉或尊严时,人类应该在其中发挥重要的作用,也就是说,我们不能自动化杀戮或羁押某人的决定。”Bengio和Russell都同意,研究人员有责任以合乎道德的方式指导人工智能技术的发展和使用。“这绝对是我们的责任,就像医生有严格的政策反对参与处决一样,”Russell说。“我不赞同那些说科学家应该只专注于科学,把所有政治事务都留给政客的人。”

着眼未来

KAIST迅速回应了国际研究界的公开信。到四月初,KAIST校长申成澈(Sung-chul Shin)发表声明,打消了研究人员的担忧:“KAIST无意参与开发致命自主武器系统和杀手机器人。”作为回应,研究人员取消了拟议的抵制。此次抵制提议的明显成功可能会激励未来的运动效仿。但许多大学可能会三思而后行,是否要进行可能导致致命自主武器的类似研究项目。Russell指出,人工智能研究界需要保持警惕。“除了否定合同本身,这是我们所能期望最好的结果,”Russell说。“许多签署者建议,我们将需要密切关注KAIST的工作,看看校长声明是否具有实际意义。”同样,Bengio表示目前对KAIST的回应感到满意。如果需要,他也似乎倾向于将来使用研究抵制的想法。“即使它不总是奏效,它也值得去做,”Bengio说。“最重要的副作用是教育人们、政府和组织了解人工智能使用(或滥用)的道德方面。”

对科幻作品中的杀手机器人感兴趣?我曾推测过《星球大战》中的银河帝国和第一秩序为何似乎回避致命自主武器。