(图片来源:Shutterstock) 还记得AlphaGo吗?你懂的,就是那个在2016年以压倒性优势击败人类最顶尖棋手的围棋人工智能;从此,我们不得不放弃人类在棋类游戏中最后的优越感,承认机器的强大。还记得那件事吗?现在,有件事值得深思:谷歌的人工智能研究部门DeepMind,也就是那个创造了AlphaGo的“仁慈”的创造者,已经将那个曾经打败人类的版本淘汰了。在一项周三发表在《自然》杂志上的研究中,研究人员描述了一种更快、更精简、自学能力更强的人工智能,它以100比0的比分击败了AlphaGo。零比零。没有。没有。毫无。这个新的人工智能天才恰如其分地被命名为AlphaGo Zero,而它称霸的秘诀确实令人着迷。

看妈妈,没有人

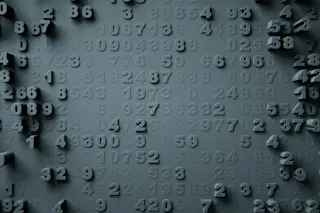

也许我们应该料到这一天。毕竟,AlphaGo的强大首先依赖于人类的专业知识。它的人工神经网络是在海量人类棋谱上训练出来的。AlphaGo逐招分析了这些棋局,然后在模拟中一遍又一遍地与自己对弈,根据它储存的人类围棋知识,在每一回合都进行超优化。AlphaGo吸收了从人类那里学到的知识,并做得更好。AlphaGo Zero则不同。研究人员没有给它的神经网络输入任何人类过去的棋谱数据。这个人工智能从零开始,完全是一张白纸,它的想象力仅限于围棋规则。AlphaGo Zero开始通过与自己在模拟对局中进行完全随机的落子来训练,从每次结果中学习一点点,并每次都改进它的神经网络。

它这样进行了三天,期间生成了490万盘棋,每盘棋产生了1600次模拟。仅用了36小时,AlphaGo Zero就准备好将它的前身从王者宝座上拉下马。相比之下,击败李世石(当时世界顶尖棋手)的AlphaGo版本,则需要数月训练,并依赖更多的硬件才能完成这项任务。DeepMind在击败李世石后,又在AlphaGo上进行了几次迭代改进。今年早些时候,AlphaGo Master在网上击败了60位世界顶尖围棋棋手。AlphaGo Zero在训练21天后就超越了AlphaGo Master。训练40天后,AlphaGo Zero可以说是有史以来最强的围棋AI。事实上,曾经击败李世石的人工指导的AlphaGo,在面对自学成才的AlphaGo Zero时,一局未胜,这让研究人员得出了一些令人震惊,甚至可能令人不寒而栗的结论。他们在研究中写道:

“这表明AlphaGo Zero可能正在学习一种与人类下棋方式在质上不同的策略……AlphaGo Zero在自我对弈训练过程中发现了令人惊叹的围棋知识。这不仅包括人类围棋知识的基本要素,还包括超越传统围棋知识范围的非标准策略。”

数千年,数百代人,无数棋局和关于棋局的书籍,人类积累了围棋的知识。而大师们能达到他们的水平,也是站在无数前人的肩膀上。围棋有着丰富的历史,至今仍能激发人们想象力是有原因的。AlphaGo Zero通过随机落子和强化学习,不仅精通了围棋,还重新发明了它。这一切都不到两个月的时间。

别急着屈服

对于一名人工智能研究员来说,构建一个拥有通用知识的人工智能,就像登陆火星一样——这样的AI可以做得无所不能。人类拥有通用知识。我们使用相同的生物硬件和软件来开车、解数学题、写诗、接棒球和下围棋。我们还能解决那些解决方案模糊、没有“赢家”且没有现成规则的问题。一个人如何能在写诗中获胜?AlphaGo Zero是迈向某种通用知识的又一步。它形成了自己的策略,并在不学习先例的情况下优化了结果。当然,这里出现的行为是新颖的,甚至可能是前所未有的。但是围棋是一个封闭的问题,有规则,并且有明确的终局定义——尽管棋局变化的数量多得惊人。像AlphaGo Zero这样的算法有可能在基于规则的任务中教会自己并达到超人类水平,在这些任务中结果是已知的:投资、保险理赔、医学诊断。但它能下围棋、写小说、开车和在蔬菜区挑出最好的番茄吗?现在还不行,但它更近了一步。